Jag tror att detta tillvägagångssätt är felaktigt, men kanske kommer det att vara mer användbart om jag förklarar varför. Att vilja veta den bästa modellen med viss information om ett stort antal variabler är ganska förståeligt. Dessutom är det en situation där människor verkar befinna sig regelbundet. Dessutom omfattar många läroböcker (och kurser) om regression stegvisa urvalsmetoder, vilket innebär att de måste vara legitima. Tyvärr är de inte det, och parningen av denna situation och mål är ganska svår att navigera framgångsrikt. Följande är en lista med problem med automatiserade stegvisa modellvalsförfaranden (tillskrivna Frank Harrell och kopieras från här):

- Det ger R-kvadrat värden som är dåligt förspända för att vara höga.

- F- och chi-kvadrat-testerna som citeras bredvid varje variabel på utskriften har inte den anspråkade fördelningen.

- Metoden ger konfidensintervall för effekter och förutspådda värden som är falskt smala; se Altman och Andersen (1989).

- Det ger p-värden som inte har rätt betydelse, och rätt korrigering för dem är ett svårt problem.

- Det ger partisk regression koefficienter som behöver krympas (koefficienterna för kvarvarande variabler är för stora; se Tibshirani [1996]).

- Det har allvarliga problem i närvaro av kollinearitet.

- Det bygger på metoder (t.ex. F-test för kapslade modeller) som var avsedda att användas för att testa förutbestämda hypoteser.

- Att öka provstorleken hjälper inte särskilt mycket; se Derksen och Keselman (1992).

- Det gör att vi inte kan tänka på problemet.

- Det använder mycket papper.

Frågan är, vad är så dåligt med dessa procedurer / varför uppstår dessa problem? De flesta som har gått en grundläggande regressionskurs är bekanta med begreppet regression till medelvärdet, så det här är vad jag använder för att förklara dessa frågor. (Även om det här kan tyckas att det inte är ämne, bör du hålla med mig, jag lovar att det är relevant.)

Föreställ dig en spårtränare på gymnasiet den första dagen i försöken. Trettio barn dyker upp. Dessa barn har någon underliggande nivå av inneboende förmåga som varken tränaren eller någon annan har direkt tillgång till. Som ett resultat gör tränaren det enda han kan göra, det vill säga att de alla kör 100 meter. Tiderna är förmodligen ett mått på deras inneboende förmåga och tas som sådana. De är dock sannolika; en viss andel av hur bra någon gör är baserat på deras faktiska förmåga och en del är slumpmässig. Föreställ dig att den verkliga situationen är följande:

set.seed (59) intrinsic_ability = runif (30, min = 9, max = 10) time = 31 - 2 * intrinsic_ability + rnorm (30 , medelvärde = 0, sd = .5)

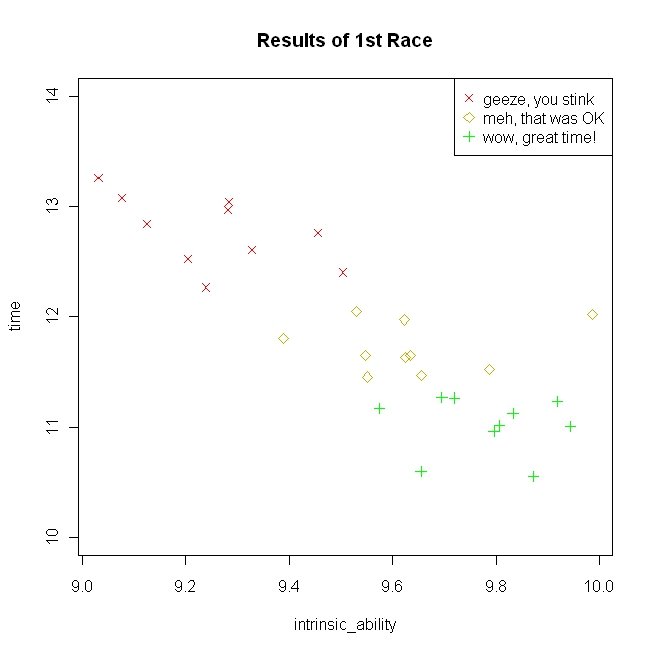

Resultaten från första loppet visas i följande figur tillsammans med tränarens kommentarer till barnen.

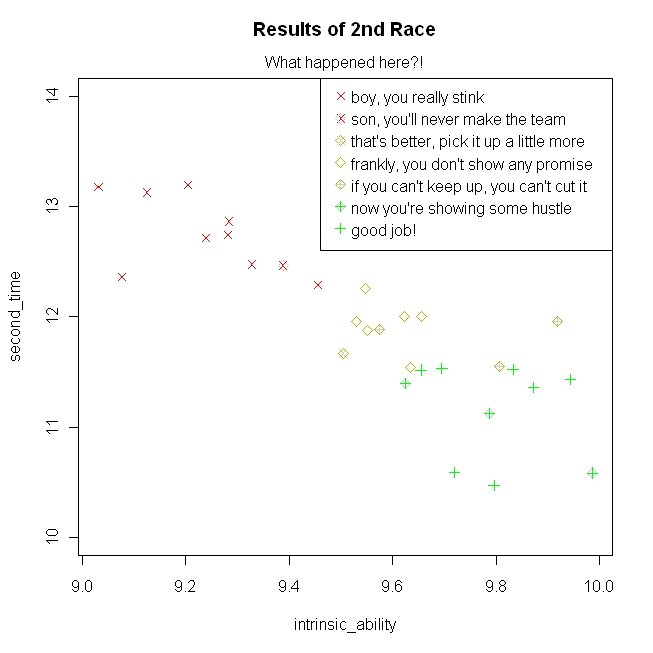

Observera att partitionering av barnen efter deras tävlingstider lämnar överlappningar på deras inneboende förmåga - detta är avgörande. Efter att ha berömt några och skrek åt andra (som tränare tenderar att göra), får han dem att springa igen. Här är resultatet av den andra loppet med tränarens reaktioner (simulerad från samma modell ovan):

Lägg märke till att deras inneboende förmåga är identisk, men tiderna studsade relativt i förhållande till det första loppet. Från tränarens synvinkel tenderade de som han skrek åt att förbättra sig, och de som han berömde tenderade att göra sämre (jag anpassade detta konkreta exempel från Kahnemans citat som listas på wiki-sidan), även om egentligen regression till medelvärdet är en enkel matematisk konsekvens av det faktum att tränaren väljer idrottare till laget baserat på ett mått som delvis är slumpmässigt.

Vad har detta nu att göra med automatiserade (t.ex. stegvisa) modellvalstekniker? Att utveckla och bekräfta en modell baserad på samma dataset kallas ibland datamuddring . Även om det finns en viss underliggande relation mellan variablerna och starkare förhållanden förväntas ge starkare poäng (t.ex. högre t-statistik), är dessa slumpmässiga variabler och de realiserade värdena innehåller fel. Således, när du väljer variabler baserat på att ha högre (eller lägre) realiserade värden, kan de vara sådana på grund av deras underliggande verkliga värde, fel eller båda. Om du fortsätter på detta sätt blir du lika förvånad som tränaren var efter andra loppet. Detta gäller oavsett om du väljer variabler baserat på hög t-statistik eller låga interkorrelationer. Det är sant att använda AIC är bättre än att använda p-värden, eftersom det straffar modellen för komplexitet, men AIC är i sig en slumpmässig variabel (om du kör en studie flera gånger och passar samma modell kommer AIC att studsa runt precis som allt annat). Tyvärr är detta bara ett problem som är inneboende för själva verklighetens epistemiska natur.

Jag hoppas att det är till hjälp.