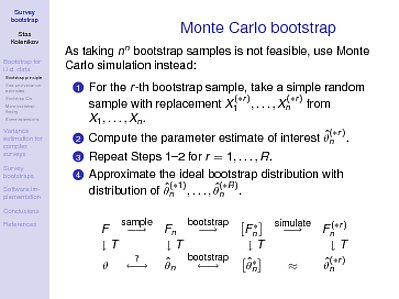

Detta är förmodligen en mer teknisk förklaring riktad till personer som förstår viss statistik och matematik (åtminstone kalkyl). Här är en bild från en kurs om undersökningens bootstraps som jag undervisade för en tid sedan:

Några förklaringar behövs naturligtvis. $ T $ är proceduren för att erhålla statistiken från existerande data (eller, för att vara tekniskt exakt, en funktion från distributionsfunktionen till reella tal; t.ex. är medelvärdet $ E [X] = \ int x {\ rm d } F $, där för samlingsfördelningsfunktionen $ F_n () $, förstås $ {\ rm d} F $ som en punktmassa vid en samplingspunkt). I populationen, betecknad med $ F () $, ger tillämpningen av $ T $ parametern av intresse $ \ theta $. Nu har vi tagit ett prov (den första pilen överst) och har den empiriska fördelningsfunktionen $ F_n () $ - vi tillämpar $ T $ på den för att få uppskattningen $ \ hat \ theta_n $. Hur långt är det från $ \ theta $, undrar vi? Vad är fördelningen som den slumpmässiga mängden $ \ hat \ theta_n $ kan ha runt $ \ theta $? Detta är frågetecknet längst ned till vänster i diagrammet, och det är denna fråga som bootstrap försöker svara på. För att återuppfatta gungens poäng är det inte frågan om populationen, utan frågan om en viss statistik och dess fördelning. Tja, det är vanligtvis bortom våra möjligheter. Men om

- $ F_n $ är tillräckligt nära $ F $, i lämplig mening, och

- kartläggningen $ T $ är tillräckligt smidig, dvs om vi ta små avvikelser från $ F () $, resultaten mappas till siffror nära $ \ theta $,

vi kan hoppas att bootstrap-proceduren fungerar. Vi låtsar nämligen att vår distribution är $ F_n () $ snarare än $ F () $, och med det kan vi underhålla alla möjliga prover - och det kommer $ n ^ n $ sådana prover, vilket bara är praktiskt för $ n \ le 5 $. Låt mig upprepa igen: bootstrap arbetar för att skapa samplingsfördelningen av $ \ hat \ theta_n ^ * $ runt den "sanna" parametern $ \ hat \ theta_n $, och vi hoppas att med de två ovanstående villkoren är denna samplingsfördelning informativ om samplingsfördelningen av $ \ hat \ theta_n $ runt $ \ theta $:

$$ \ hat \ theta_n ^ * \ mbox {till} \ hat \ theta_n \ mbox {är som} \ hat \ theta_n \ mbox {to} \ theta $$

Nu, istället för att bara gå en väg längs pilarna och förlora lite information / noggrannhet längs dessa pilar, kan vi gå tillbaka och säga något om variationen på $ \ hat \ theta_n ^ * $ runt $ \ hat \ theta_n $.

Ovanstående villkor är utpekade det yttersta tekniska i Halls (1991) bok. Förståelsen av kalkyl som jag sa kan krävas som en förutsättning för att stirra på den här bilden är det andra antagandet om jämnhet: på ett mer formellt språk måste den funktionella $ T $ ha ett svagt derivat. Det första villkoret är naturligtvis ett asymptotiskt uttalande: ju större ditt prov, desto närmare bör $ F_n $ bli $ F $; och avstånden från $ \ hat \ theta_n ^ * $ till $ \ hat \ theta_n $ bör vara i samma storleksordning som de från $ \ hat \ theta_n $ till $ \ theta $. Dessa villkor kan gå sönder och de bryts i ett antal praktiska situationer med konstigt nog statistik och / eller samplingsscheman som inte producerar empiriska distributioner som är tillräckligt nära $ F $.

Varifrån kommer de 1000 exemplen, eller vad det magiska numret kan vara, ifrån? Det kommer från vår oförmåga att rita alla $ n ^ n $ -prover, så vi tar bara en slumpmässig delmängd av dessa. Den rätta "simulera" pilen anger ytterligare en approximation som vi gör på väg för att få fördelningen av $ \ hat \ theta_n $ runt $ \ theta $, och det vill säga att vår Monte Carlo simulerade fördelning av $ \ hat \ theta_n ^ {(* r)} $ är en tillräckligt bra approximation av den fullständiga bootstrap-fördelningen av $ \ hat \ theta_n ^ * $ runt $ \ hat \ theta_n $.